主题

- #LLM

- #個人隱私

- #語言模型

- #Ollama

- #本地安裝

撰写: 2024-11-09

撰写: 2024-11-09 17:46

Ollama是一個用於運行本地語言模型的輕量級框架。此框架將模型的權重、設定和數據集捆綁到一個整合套件中,旨在優化各種AI應用程式。

您可以在Ollama官方網站上下載適用於Mac、Linux和Windows的安裝檔案。

安裝完成後,請執行Ollama應用程式。

您可以在終端機輸入以下指令:

Ollama也提供API以進行更詳細的互動。更多資訊,請瀏覽:

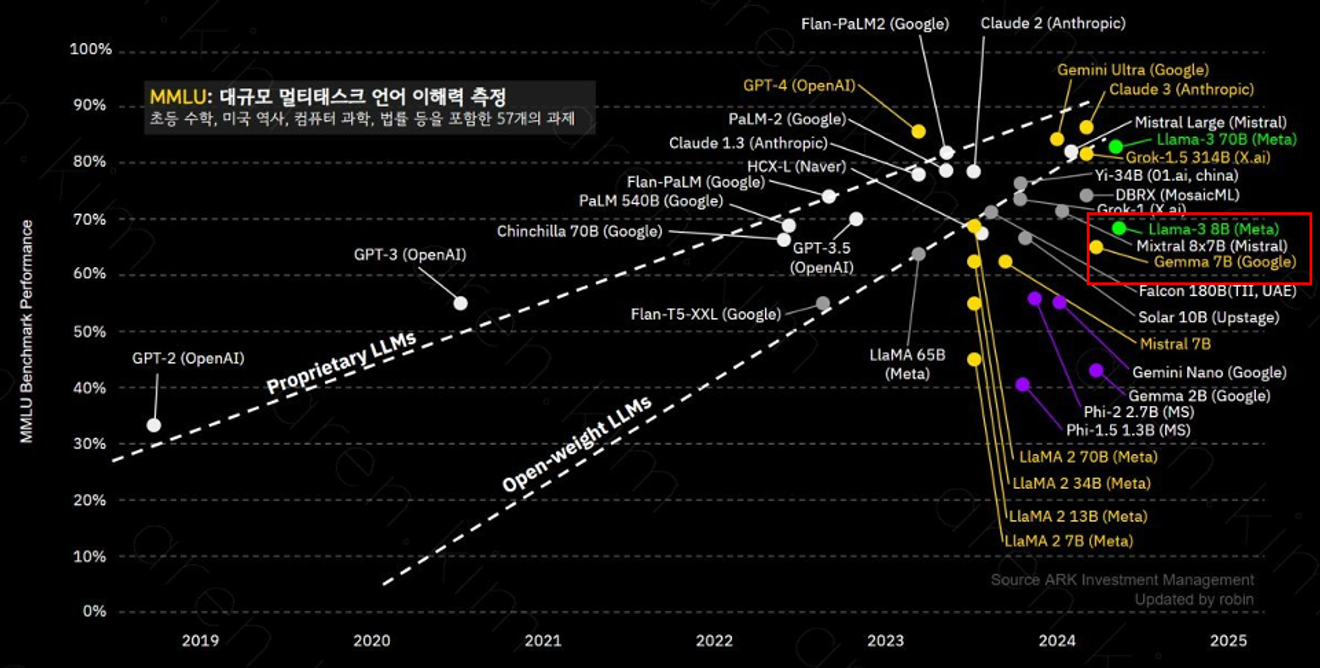

Ollama支援多種模型,其中llama-3 8B模型擁有8億個參數,在複雜語境理解和問題解決方面表現出色。每個模型的效能會因參數數量和訓練數據而異,因此根據您的用途選擇合適的模型非常重要。

llama-3 8B模型提供與GPT-3.5類似的效能。

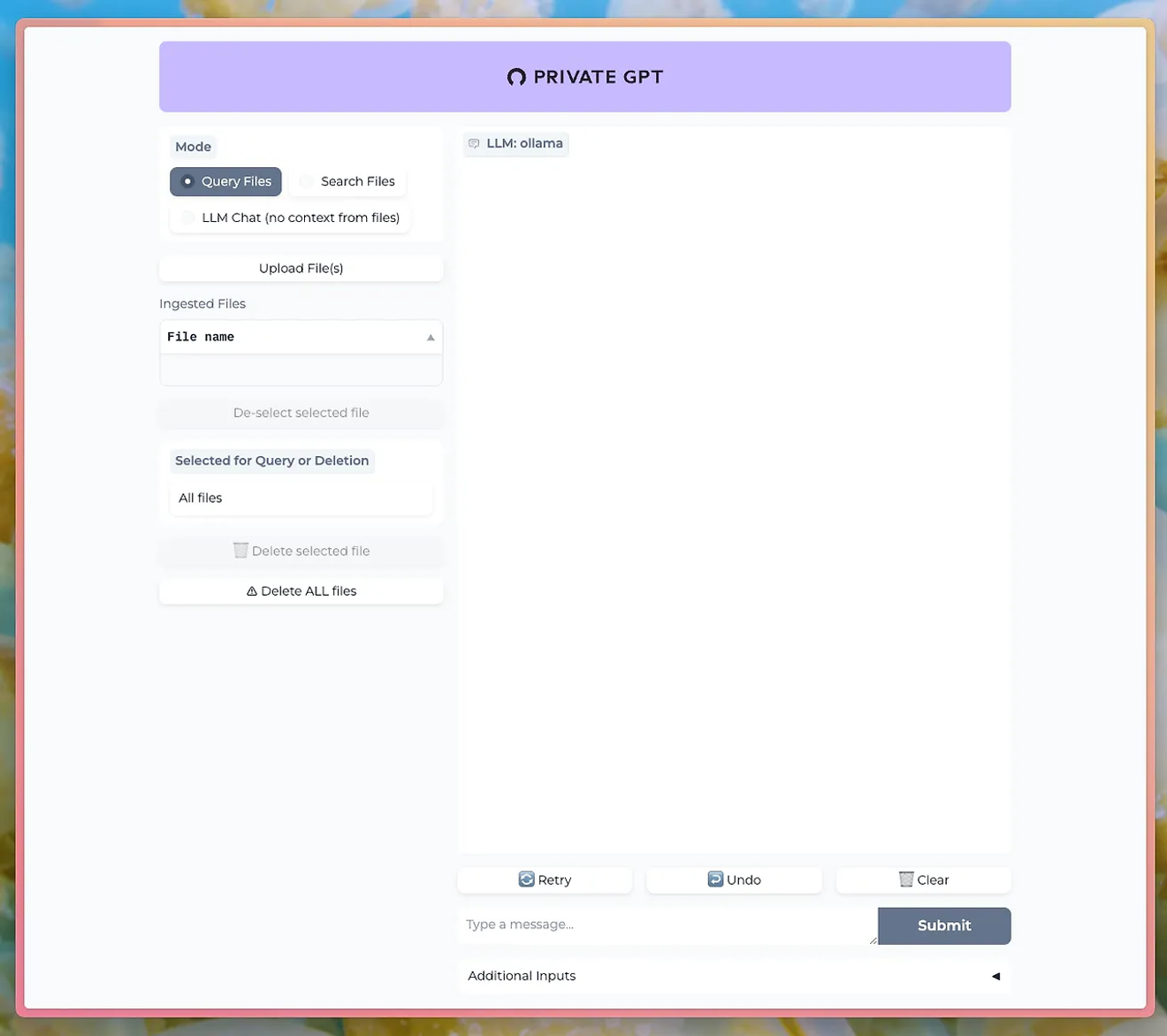

您可以使用PrivateGPT等工具,透過Ollama的LLM與聊天介面進行對話。

http://PrivateGPT GitHub

若要使用文件上傳功能,您需要安裝Ollama的nomic-embed-text模型。

使用Ollama,您可以直接體驗強大的自然語言處理功能,同時保持個人隱私和數據安全。這在重視數據敏感性的業務或研究中尤其具有優勢。

學習使用Ollama,並在本地運行您自己的LLM。把握機會直接控制高性能的自然語言處理功能,並立即查看結果。

评论0