Chủ đề

- #Cài đặt cục bộ

- #Mô hình ngôn ngữ

- #Ollama

- #LLM

- #Bảo mật thông tin cá nhân

Đã viết: 2024-11-09

Đã viết: 2024-11-09 17:46

Ollama là một framework nhẹ để chạy các mô hình ngôn ngữ cục bộ. Framework này được thiết kế để đóng gói trọng số mô hình, cấu hình và tập dữ liệu thành một gói tích hợp duy nhất, được tối ưu hóa cho nhiều ứng dụng AI khác nhau.

Bạn có thể tải xuống tệp cài đặt cho Mac, Linux và Windows từ trang chủ của Ollama.

Sau khi cài đặt hoàn tất, hãy chạy ứng dụng Ollama.

Bạn có thể nhập các lệnh sau trong terminal:

Ollama cũng cung cấp API để tương tác chi tiết hơn. Để biết thêm thông tin, hãy truy cập:

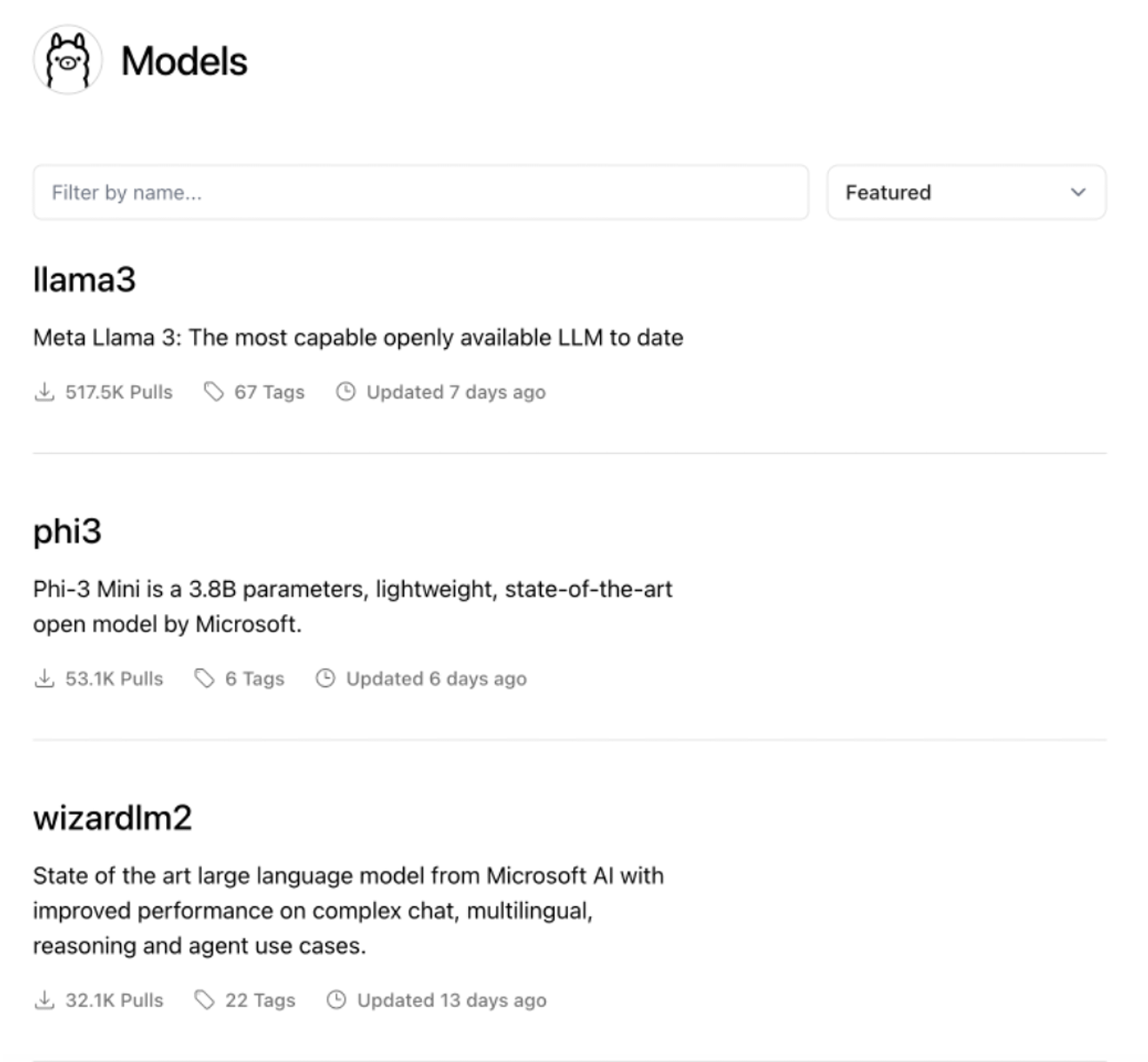

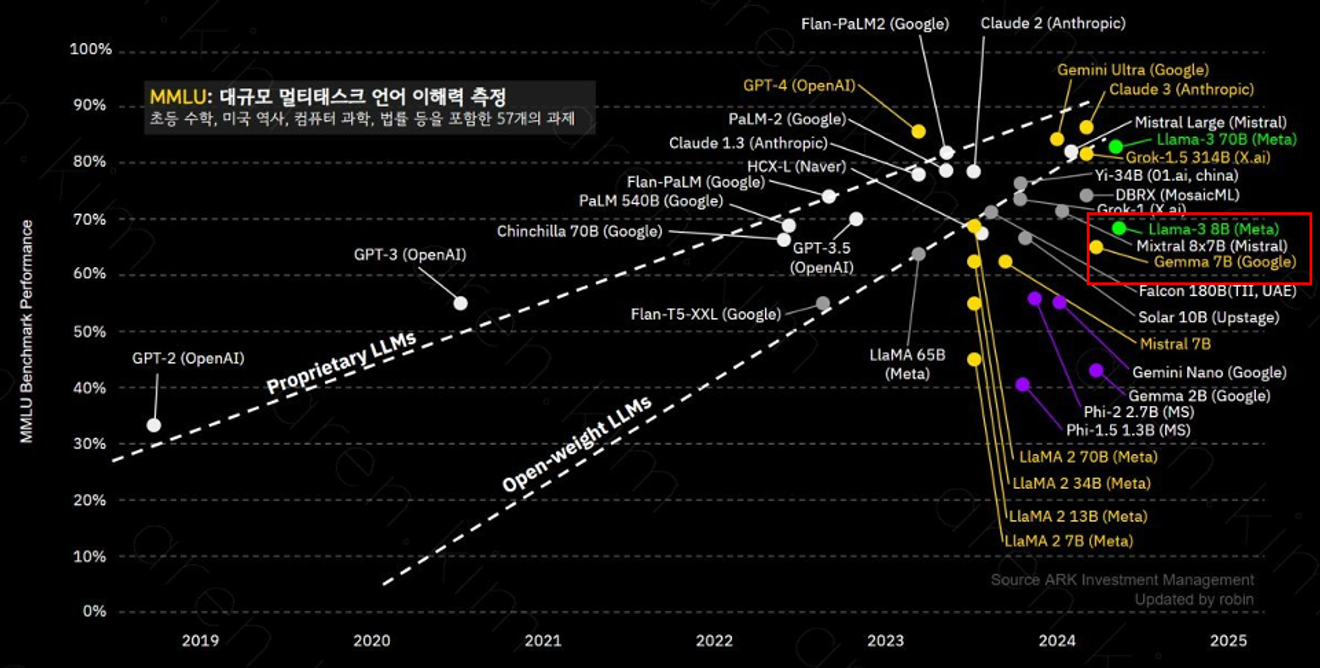

Ollama hỗ trợ nhiều mô hình khác nhau, trong đó mô hình llama-3 8B có 8 tỷ tham số, rất phù hợp cho việc hiểu ngữ cảnh phức tạp và giải quyết vấn đề. Hiệu suất của mỗi mô hình có thể khác nhau tùy thuộc vào số lượng tham số và dữ liệu huấn luyện, vì vậy điều quan trọng là phải chọn mô hình phù hợp với mục đích sử dụng.

Mô hình llama-3 8B cung cấp hiệu suất tương tự như GPT-3.5.

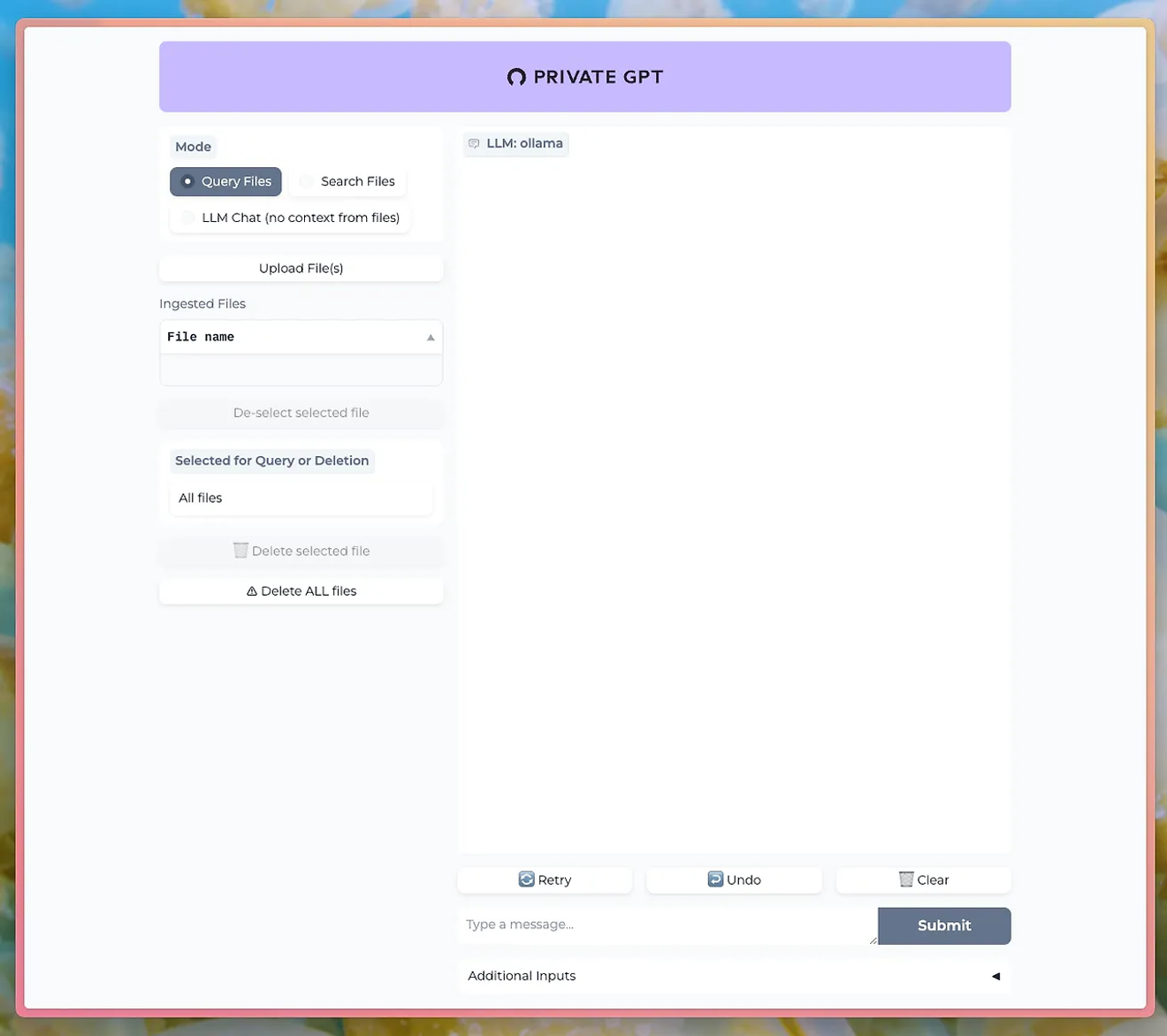

Bạn có thể sử dụng các công cụ như PrivateGPT để trò chuyện thông qua giao diện người dùng trò chuyện với LLM của Ollama.

http://PrivateGPT GitHub

Để sử dụng chức năng tải lên tài liệu, bạn cần cài đặt mô hình nomic-embed-text của Ollama.

Với Ollama, bạn có thể trải nghiệm trực tiếp sức mạnh của xử lý ngôn ngữ tự nhiên đồng thời duy trì quyền riêng tư và bảo mật dữ liệu. Điều này đặc biệt hữu ích trong các doanh nghiệp hoặc nghiên cứu có độ nhạy cảm dữ liệu cao.

Hãy làm quen với cách sử dụng Ollama và chạy LLM của riêng bạn ở cục bộ. Đừng bỏ lỡ cơ hội tự mình kiểm soát các chức năng xử lý ngôn ngữ tự nhiên hiệu suất cao và xem kết quả ngay lập tức.

Bình luận0