Assunto

- #Instalação local

- #Modelo de linguagem

- #LLM

- #Proteção de dados pessoais

- #Ollama

Criado: 2024-11-09

Criado: 2024-11-09 17:46

O Ollama é um framework leve para executar modelos de linguagem locais. Este framework agrupa os pesos do modelo, as configurações e os conjuntos de dados em um único pacote integrado, projetado para otimizar diversos aplicativos de IA.

Você pode baixar os arquivos de instalação para Mac, Linux e Windows no site do Ollama.

Após a instalação, execute o aplicativo Ollama.

Você pode inserir os seguintes comandos no terminal:

O Ollama também fornece uma API para interações mais detalhadas. Para mais informações, visite:

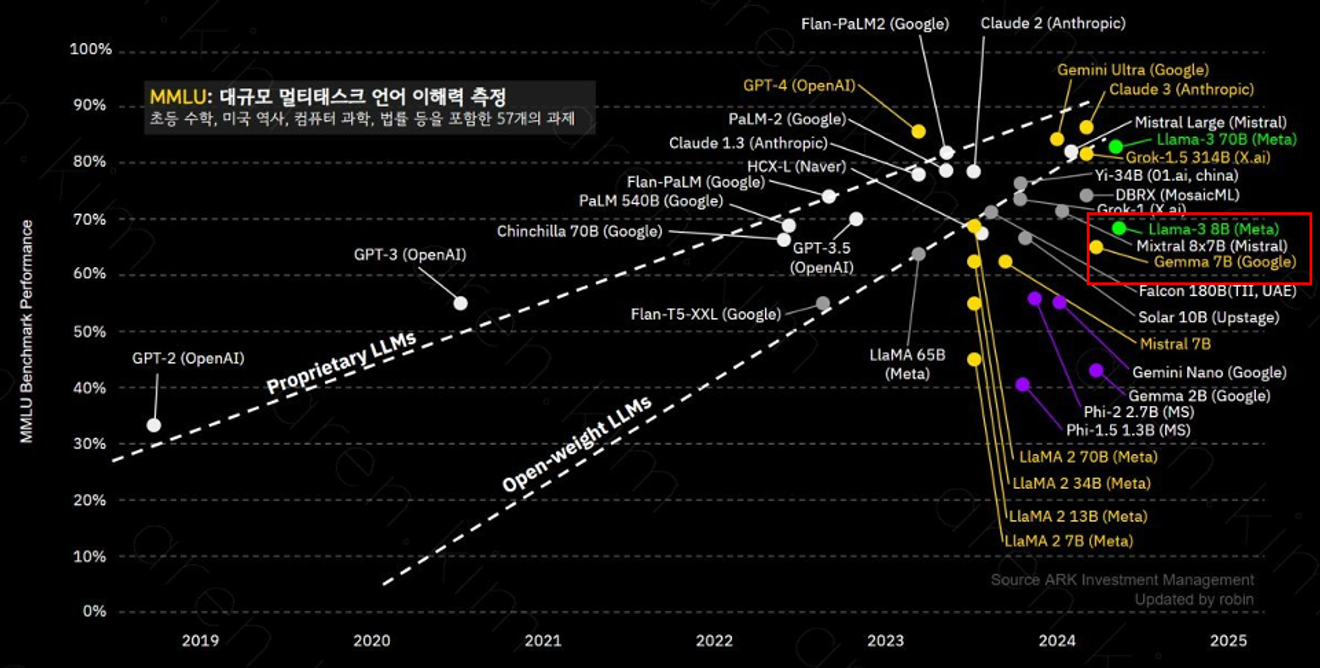

O Ollama suporta vários modelos, sendo que o modelo llama-3 8B possui 8 bilhões de parâmetros, sendo excelente para compreensão de contextos complexos e resolução de problemas. O desempenho de cada modelo pode variar dependendo do número de parâmetros e dos dados de treinamento, portanto, é importante selecionar o modelo adequado ao seu propósito.

O modelo llama-3 8B oferece desempenho semelhante ao GPT-3.5.

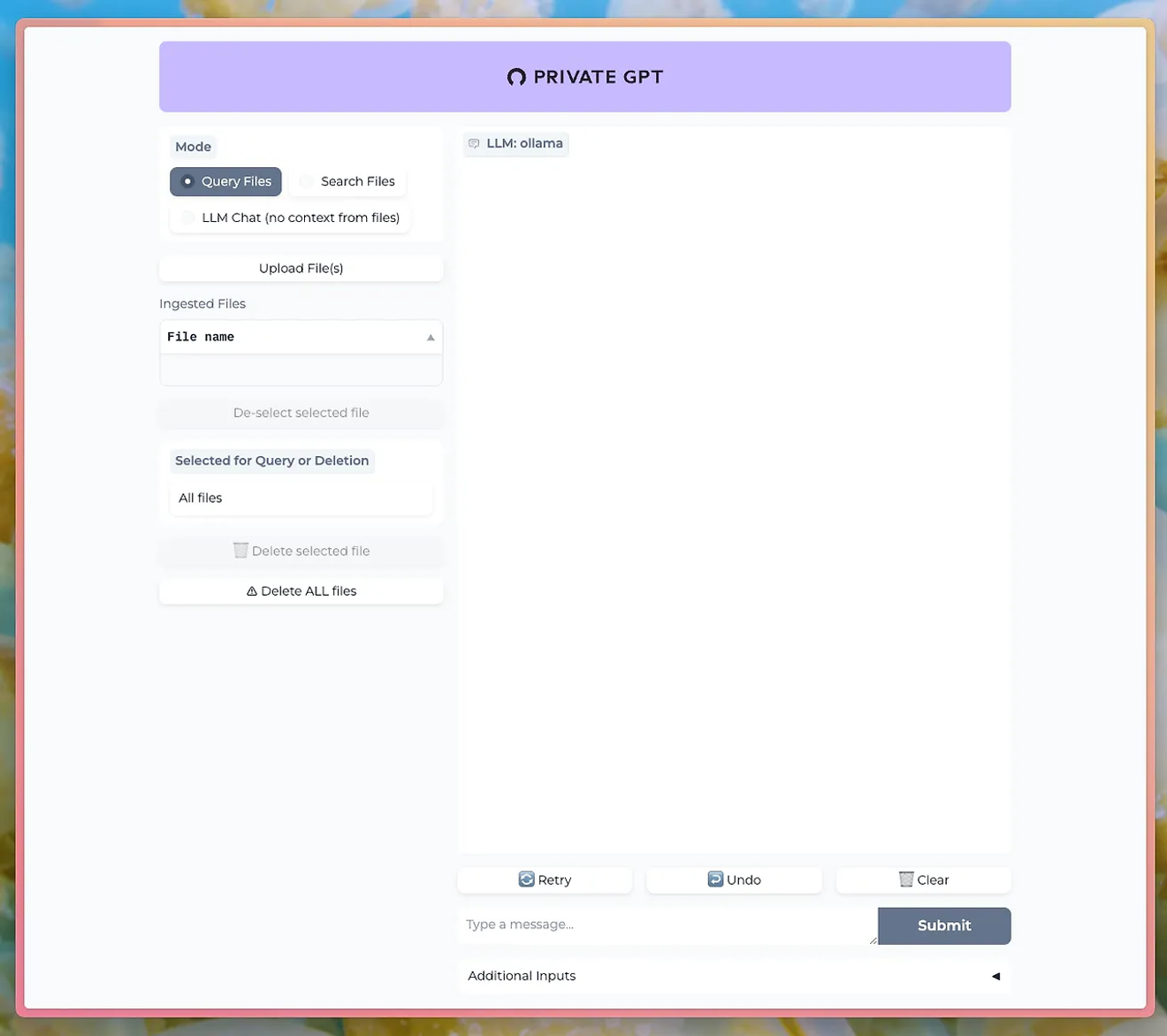

Usando ferramentas como o PrivateGPT, você pode conversar com o LLM do Ollama através de uma interface de chat.

http://PrivateGPT GitHub

Para usar o recurso de upload de documentos, você precisa instalar o modelo nomic-embed-text do Ollama.

Usando o Ollama, você pode experimentar os recursos poderosos do processamento de linguagem natural, mantendo a privacidade e a segurança dos seus dados. Isso é especialmente vantajoso para empresas ou pesquisas onde a sensibilidade dos dados é crucial.

Aprenda a usar o Ollama e execute seu próprio LLM localmente. Não perca a oportunidade de controlar diretamente os recursos de processamento de linguagem natural de alto desempenho e ver os resultados instantaneamente.

Comentários0