Temat

- #Ollama

- #Model językowy

- #LLM

- #Ochrona prywatności

- #Instalacja lokalna

Utworzono: 2024-11-09

Utworzono: 2024-11-09 17:46

Ollama to lekka infrastruktura do uruchamiania lokalnych modeli językowych. Infrastruktura ta łączy w sobie wagi modelu, ustawienia i zestawy danych w jeden zintegrowany pakiet, zaprojektowany tak, aby był zoptymalizowany pod kątem różnych aplikacji AI.

Pliki instalacyjne dla systemów Mac, Linux i Windows można pobrać ze strony głównej Ollama.

Po zakończeniu instalacji uruchom aplikację Ollama.

W terminalu możesz wpisać następujące komendy:

Ollama oferuje również API do bardziej szczegółowej interakcji. Więcej informacji znajdziesz tutaj:

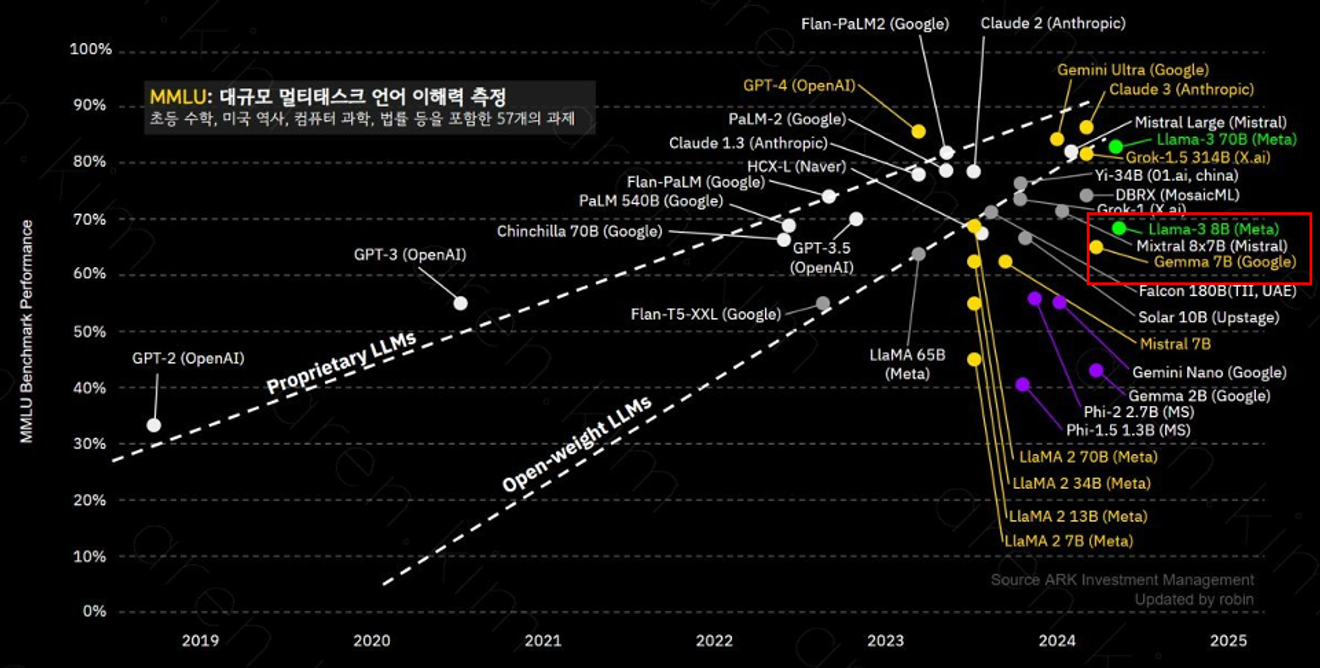

Ollama obsługuje różne modele, a model llama-3 8B, posiadający 8 miliardów parametrów, wyróżnia się doskonałym zrozumieniem złożonych kontekstów i rozwiązywaniem problemów. Wydajność poszczególnych modeli może się różnić w zależności od liczby parametrów i danych treningowych, dlatego ważne jest wybranie modelu odpowiedniego do zamierzonego celu.

Model llama-3 8B oferuje wydajność zbliżoną do GPT-3.5.

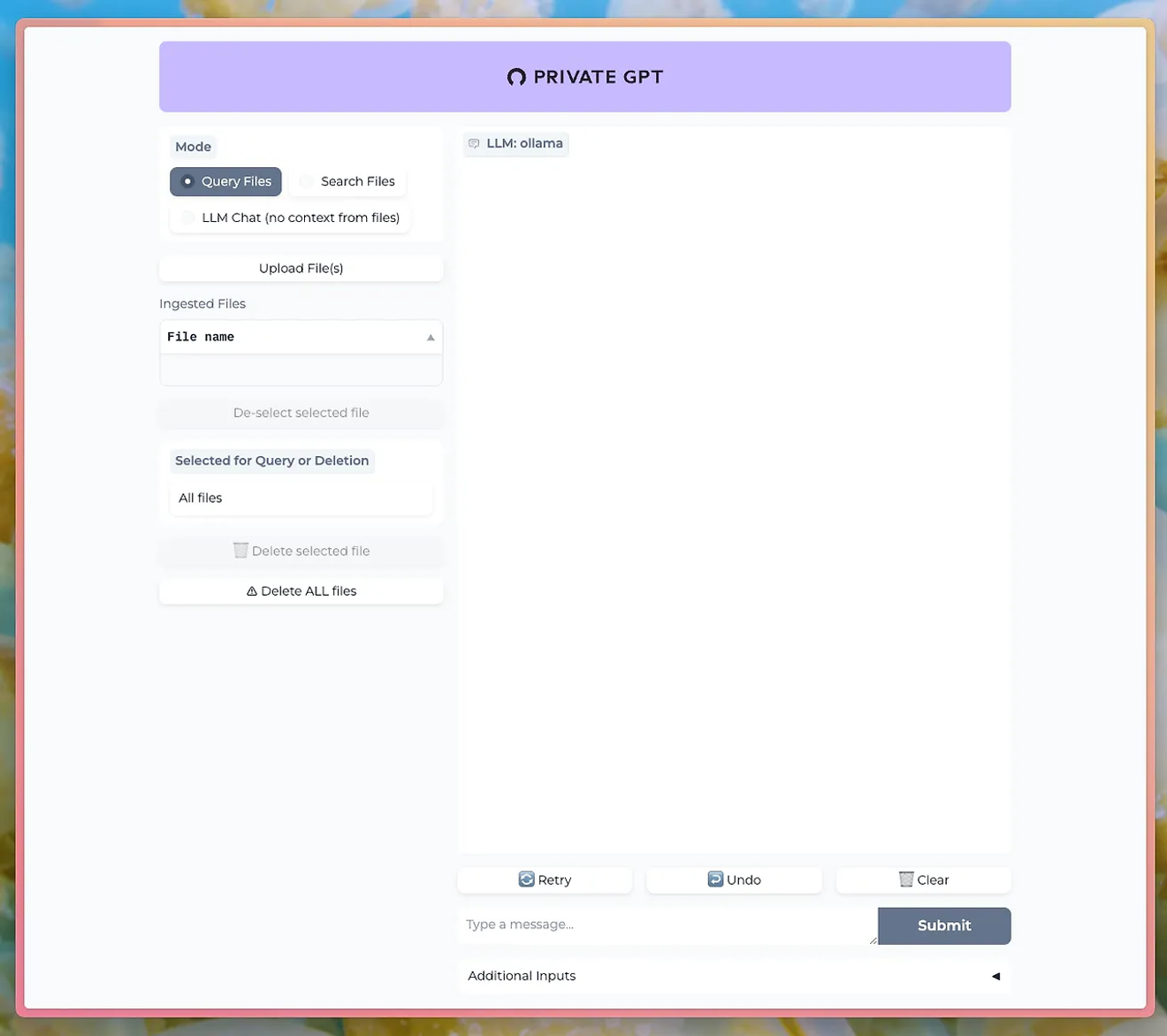

Korzystając z narzędzi takich jak PrivateGPT, możesz prowadzić rozmowy za pomocą interfejsu czatu z wykorzystaniem modelu LLM Ollama.

http://PrivateGPT GitHub

Aby korzystać z funkcji wgrywania dokumentów, należy zainstalować model nomic-embed-text z Ollama.

Ollama pozwala na bezpośrednie doświadczenie potężnych funkcji przetwarzania języka naturalnego, jednocześnie zachowując prywatność i bezpieczeństwo danych. Jest to szczególnie korzystne w firmach lub badaniach, gdzie ochrona danych jest priorytetem.

Naucz się korzystać z Ollama i uruchom własny LLM lokalnie. Nie przegap okazji do bezpośredniej kontroli zaawansowanych funkcji przetwarzania języka naturalnego i natychmiastowego sprawdzania wyników.

Komentarze0