주제

- #LLM

- #로컬 설치

- #Ollama

- #개인 정보 보호

- #언어 모델

작성: 2024-11-09

작성: 2024-11-09 17:46

Ollama는 로컬 언어 모델을 실행하기 위한 경량 프레임워크입니다. 이 프레임워크는 모델의 가중치, 설정, 그리고 데이터셋을 하나의 통합 패키지로 묶어 다양한 AI 응용 프로그램에 최적화되도록 설계되었습니다.

Ollama 홈페이지에서 Mac, Linux, Windows용 설치 파일을 다운로드할 수 있습니다.

설치가 완료되면 Ollama 앱을 실행합니다.

터미널에서 다음과 같은 명령어를 입력할 수 있습니다:

Ollama는 더 세부적인 상호작용을 위한 API도 제공합니다. 자세한 정보는 다음을 방문하세요:

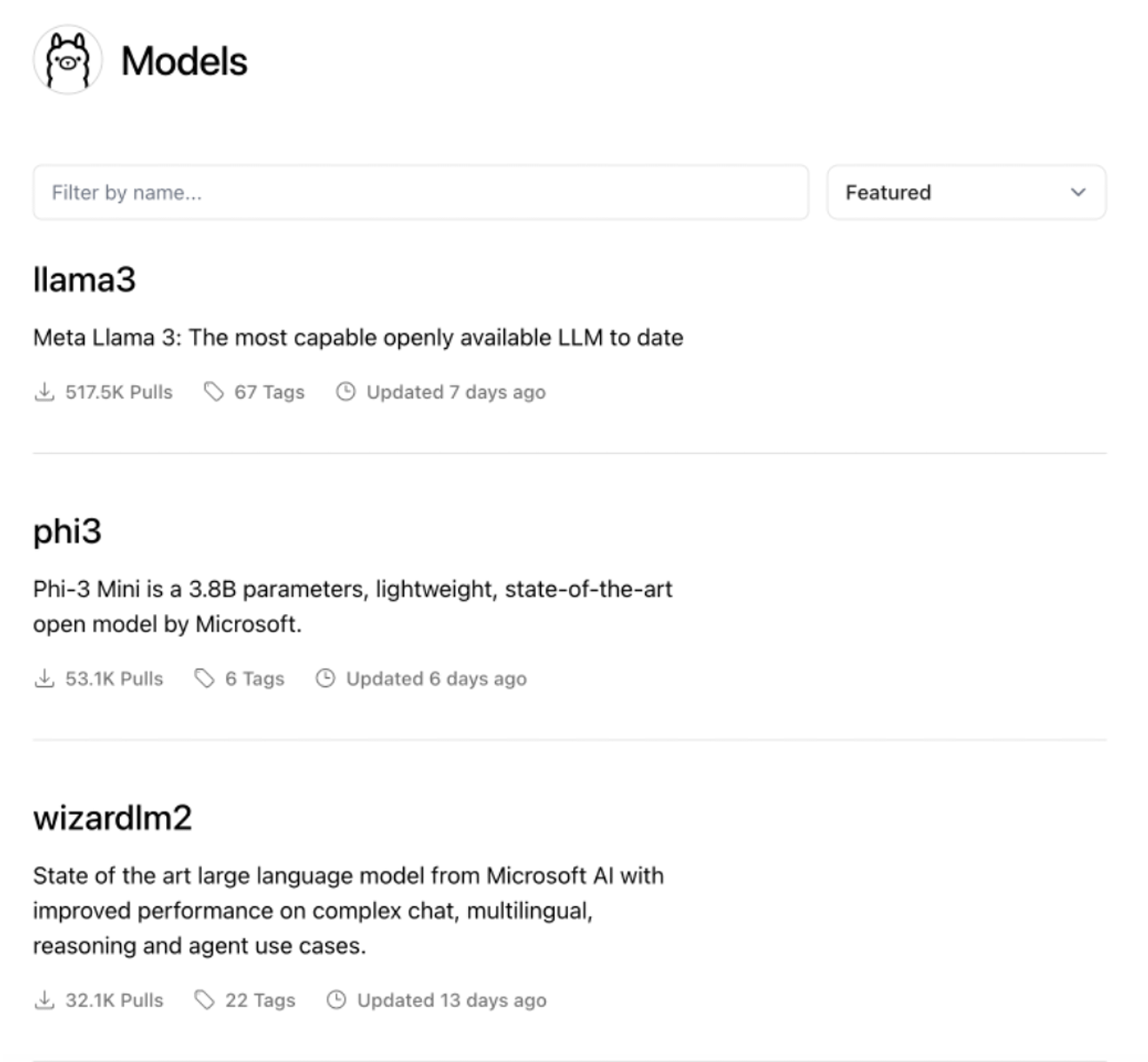

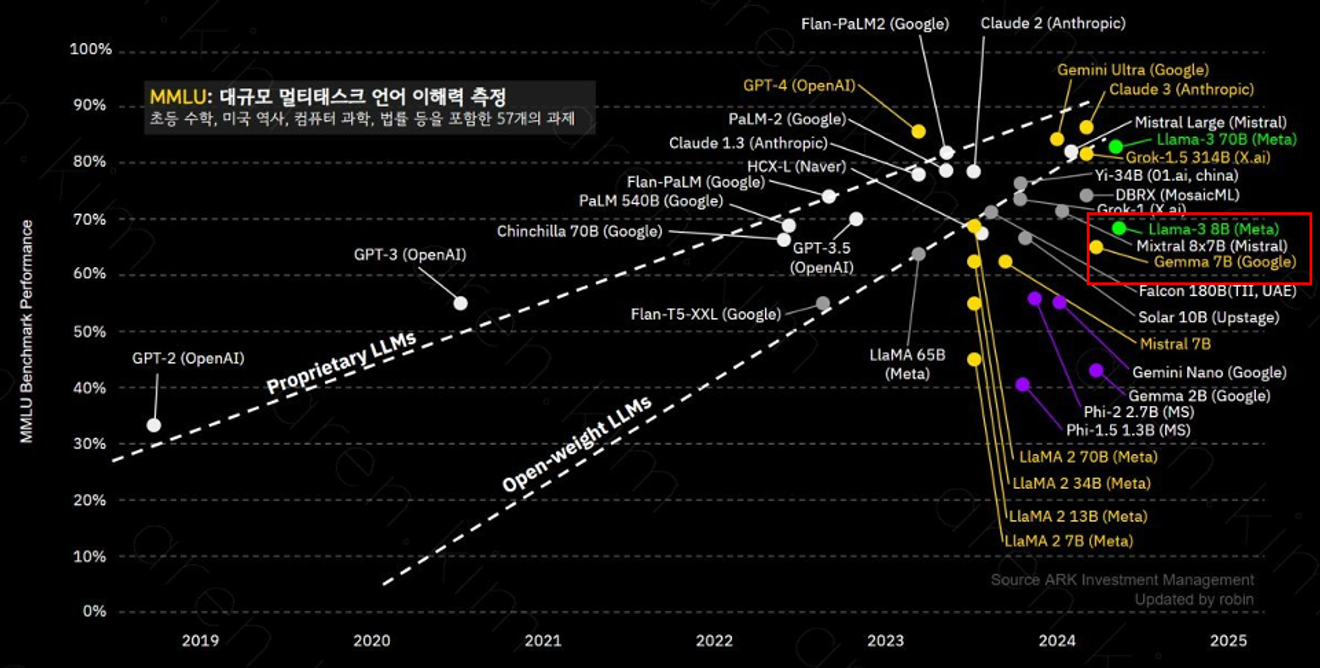

Ollama는 다양한 모델을 지원하며, 그 중에서도 llama-3 8B 모델은 8억 개의 파라미터를 갖추고 있어 복잡한 문맥 이해와 문제 해결에 탁월합니다. 각 모델의 성능은 파라미터 수와 훈련 데이터에 따라 달라질 수 있으므로 사용 목적에 맞게 선택하는 것이 중요합니다.

llama-3 8B 모델은 GPT-3.5와 비슷한 성능을 제공합니다.

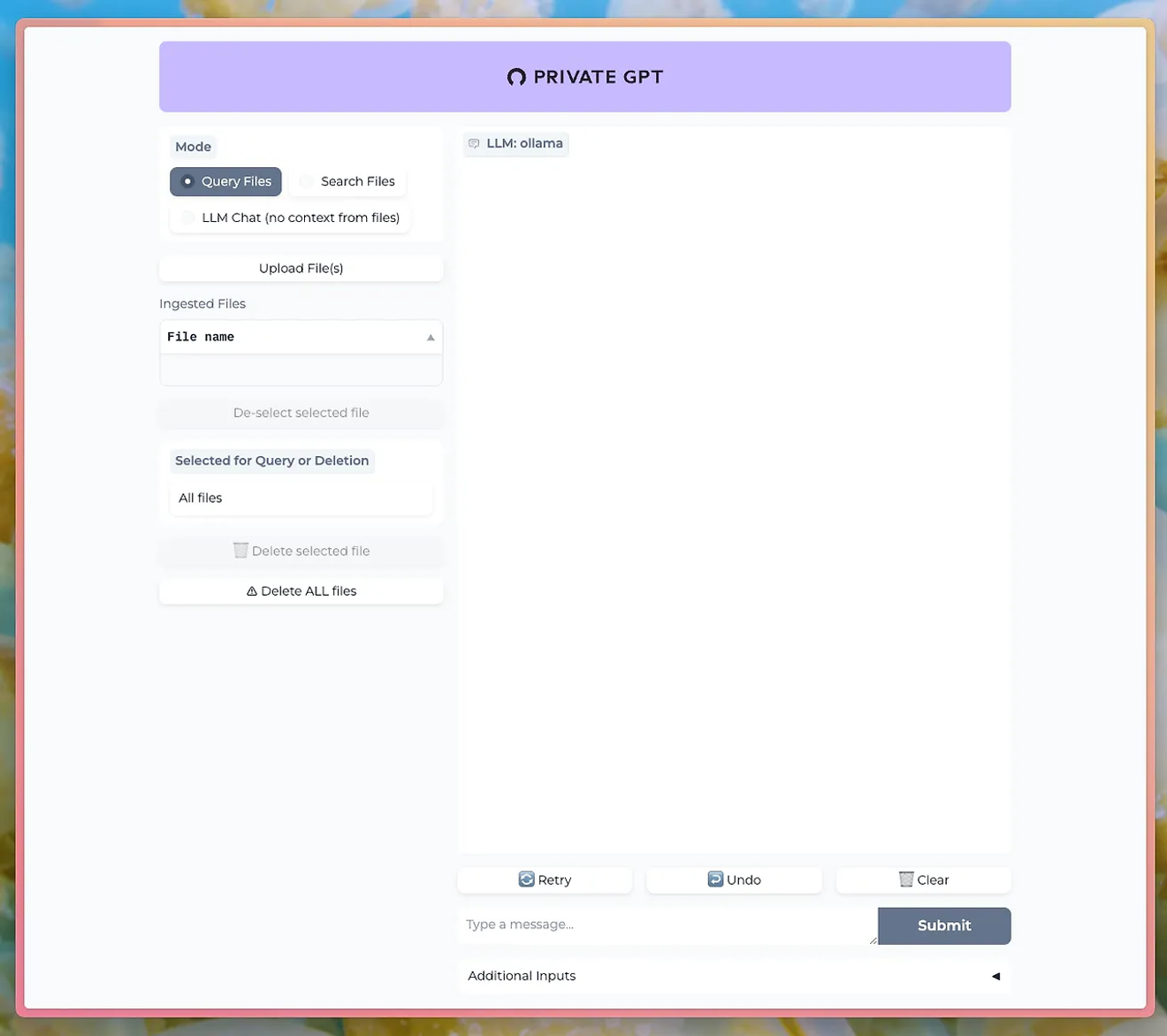

PrivateGPT와 같은 도구를 이용하면 Ollama의 LLM을 통해 채팅 UI로 대화를 나눌 수 있습니다.

http://PrivateGPT GitHub

문서 업로드 기능을 사용하려면 Ollama의 nomic-embed-text 모델을 설치해야 합니다.

Ollama를 사용하면 개인 정보 보호 및 데이터 보안을 유지하면서도 강력한 자연어 처리 기능을 직접 경험할 수 있습니다. 특히 데이터 민감성이 중요한 비즈니스나 연구에서 큰 장점으로 작용합니다.

Ollama 사용법을 익히고 로컬에서 자신만의 LLM을 구동해 보세요. 고성능의 자연어 처리 기능을 직접 제어하고 결과를 즉시 확인할 수 있는 기회를 놓치지 마십시오

댓글0