主題

- #Ollama

- #個人情報保護

- #LLM

- #言語モデル

- #ローカルインストール

作成: 2024-11-09

作成: 2024-11-09 17:46

Ollamaは、ローカル言語モデルを実行するための軽量フレームワークです。このフレームワークは、モデルの重み、設定、そしてデータセットを単一の統合パッケージにバンドルし、さまざまなAIアプリケーションに最適化されるように設計されています。

Ollamaのホームページから、Mac、Linux、Windows用のインストールファイルがダウンロードできます。

インストールが完了したら、Ollamaアプリを実行します。

ターミナルで、以下のコマンドを入力できます。

Ollamaは、より詳細なインタラクションのためのAPIも提供しています。詳細については、以下をご覧ください。

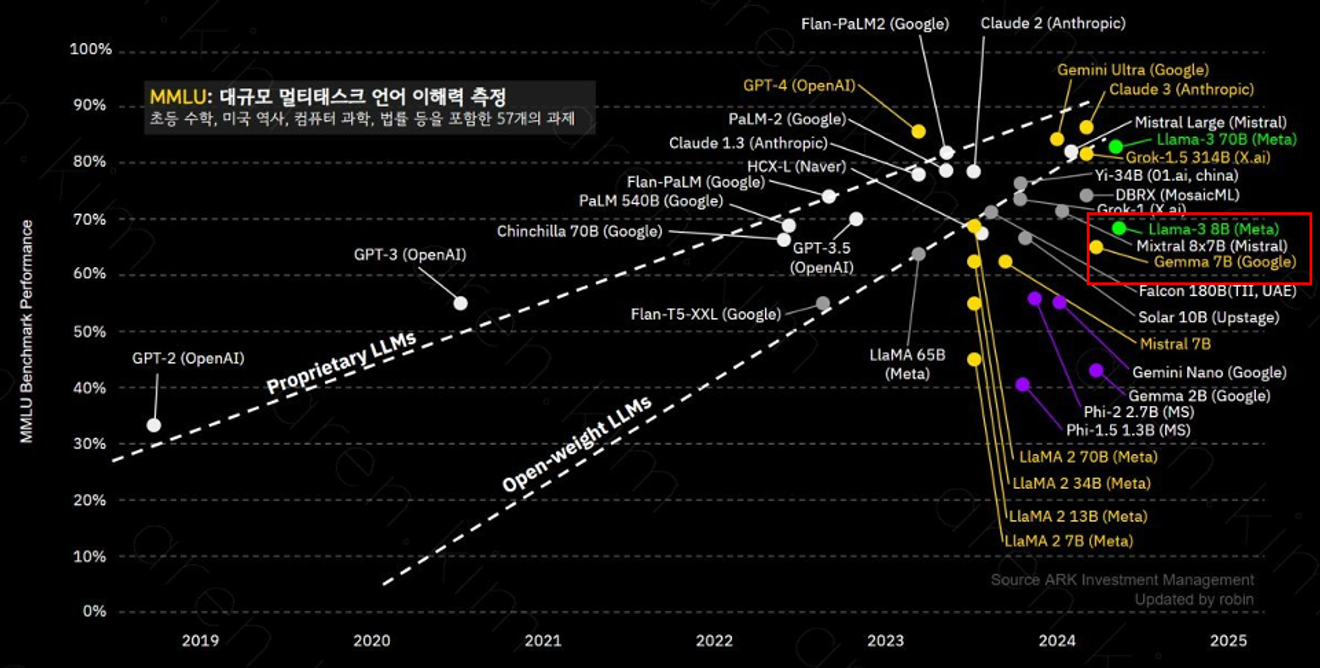

Ollamaはさまざまなモデルをサポートしており、その中でもllama-3 8Bモデルは8億個のパラメータを備えており、複雑なコンテキストの理解と問題解決に優れています。各モデルのパフォーマンスは、パラメータの数とトレーニングデータによって異なる可能性があるため、使用目的に合わせて選択することが重要です。

llama-3 8Bモデルは、GPT-3.5と同様のパフォーマンスを提供します。

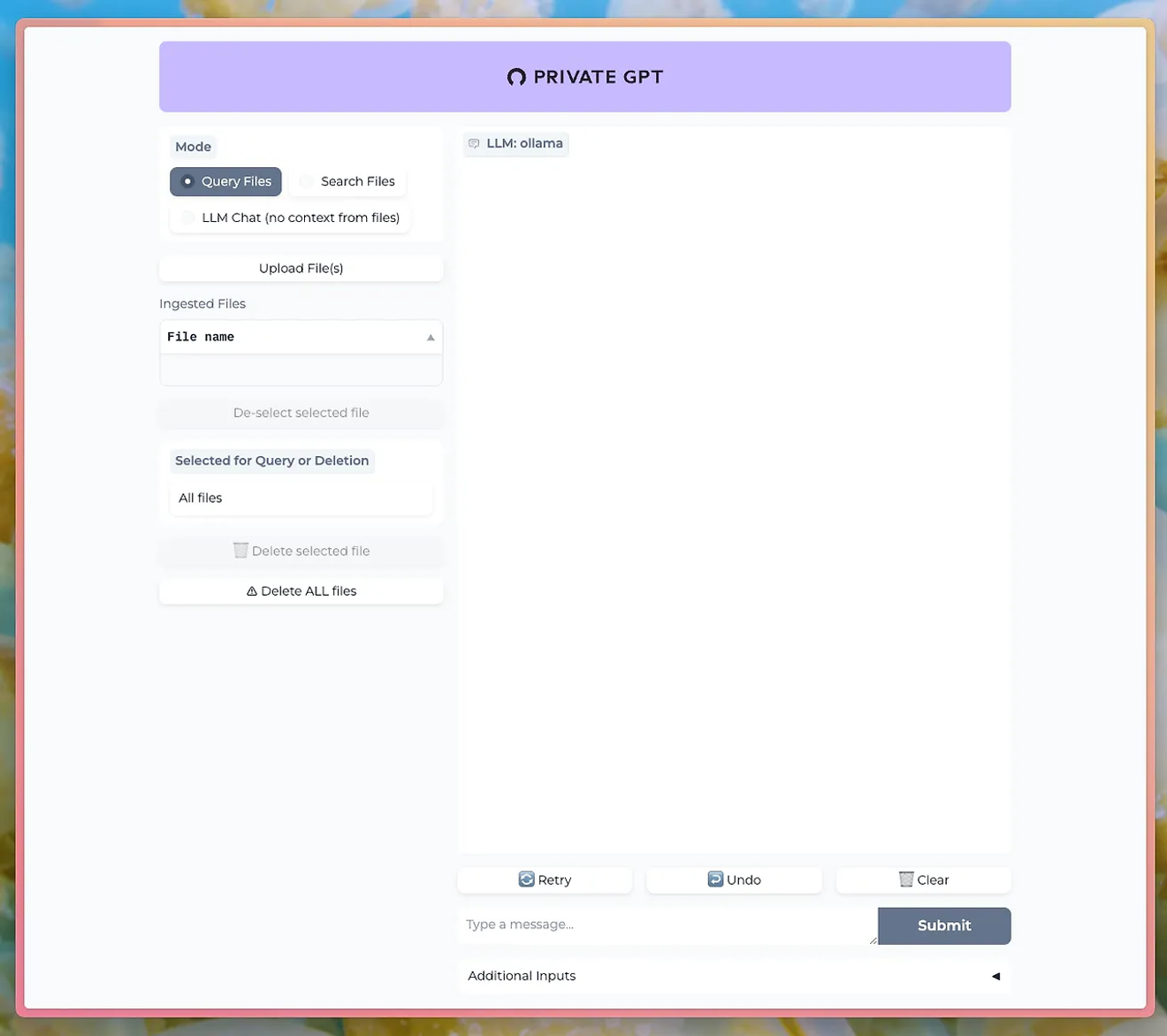

PrivateGPTなどのツールを使用すると、OllamaのLLMを介してチャットUIで対話できます。

http://PrivateGPT GitHub

ドキュメントアップロード機能を使用するには、Ollamaのnomic-embed-textモデルをインストールする必要があります。

Ollamaを使用すると、個人情報保護とデータセキュリティを維持しながら、強力な自然言語処理機能を直接体験できます。特に、データの機密性が重要なビジネスや研究において大きなメリットとなります。

Ollamaの使い方を学び、ローカルで独自のLLMを動かしてみましょう。高性能の自然言語処理機能を直接制御し、結果をすぐに確認できる機会を逃さないでください。

コメント0