Argomento

- #Protezione dei dati personali

- #LLM

- #Modello linguistico

- #Ollama

- #Installazione locale

Creato: 2024-11-09

Creato: 2024-11-09 17:46

Ollama è un framework leggero per l'esecuzione di modelli linguistici di grandi dimensioni (LLM) locali. Questo framework è progettato per raggruppare i pesi del modello, le impostazioni e i dataset in un unico pacchetto integrato, ottimizzandolo per diverse applicazioni di intelligenza artificiale.

È possibile scaricare i file di installazione per Mac, Linux e Windows dalla pagina iniziale di Ollama.

Una volta completata l'installazione, eseguire l'applicazione Ollama.

Nel terminale, è possibile immettere i seguenti comandi:

Ollama fornisce anche un'API per interazioni più dettagliate. Per maggiori informazioni, visitare:

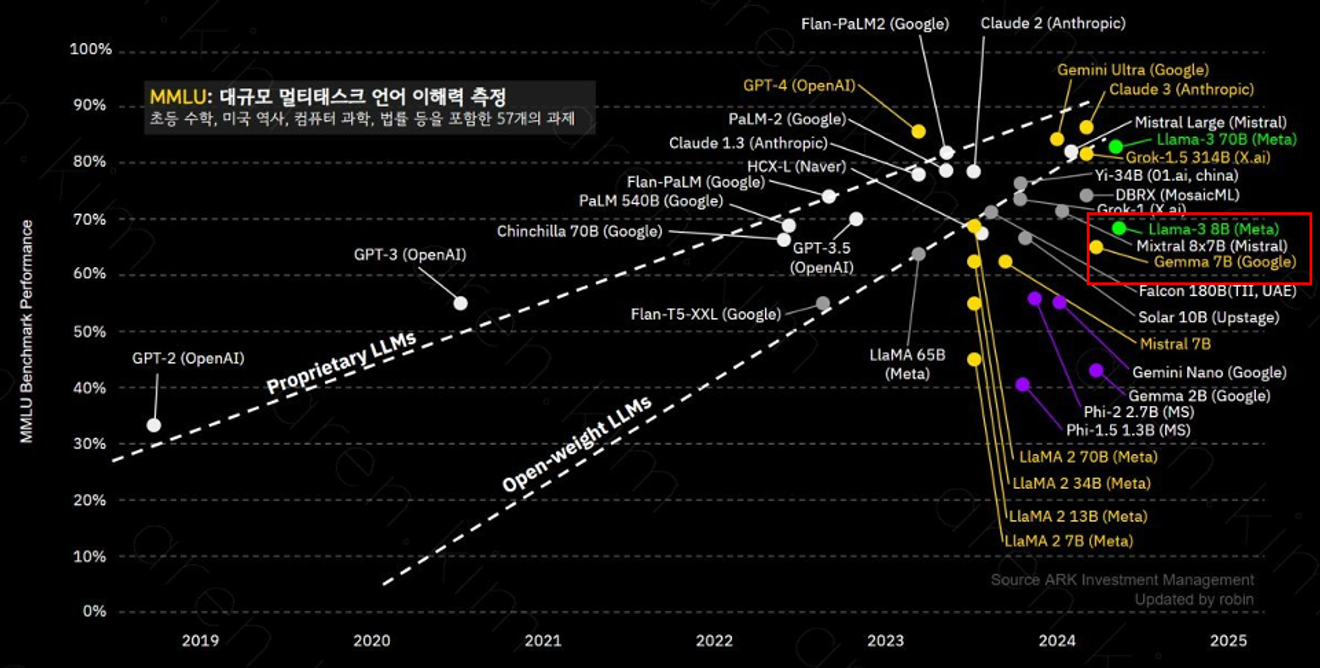

Ollama supporta diversi modelli, tra cui il modello llama-3 8B, che con i suoi 8 miliardi di parametri, eccelle nella comprensione di contesti complessi e nella risoluzione di problemi. Le prestazioni di ogni modello possono variare in base al numero di parametri e ai dati di addestramento, quindi è importante scegliere quello più adatto alle proprie esigenze.

Il modello llama-3 8B offre prestazioni simili a GPT-3.5.

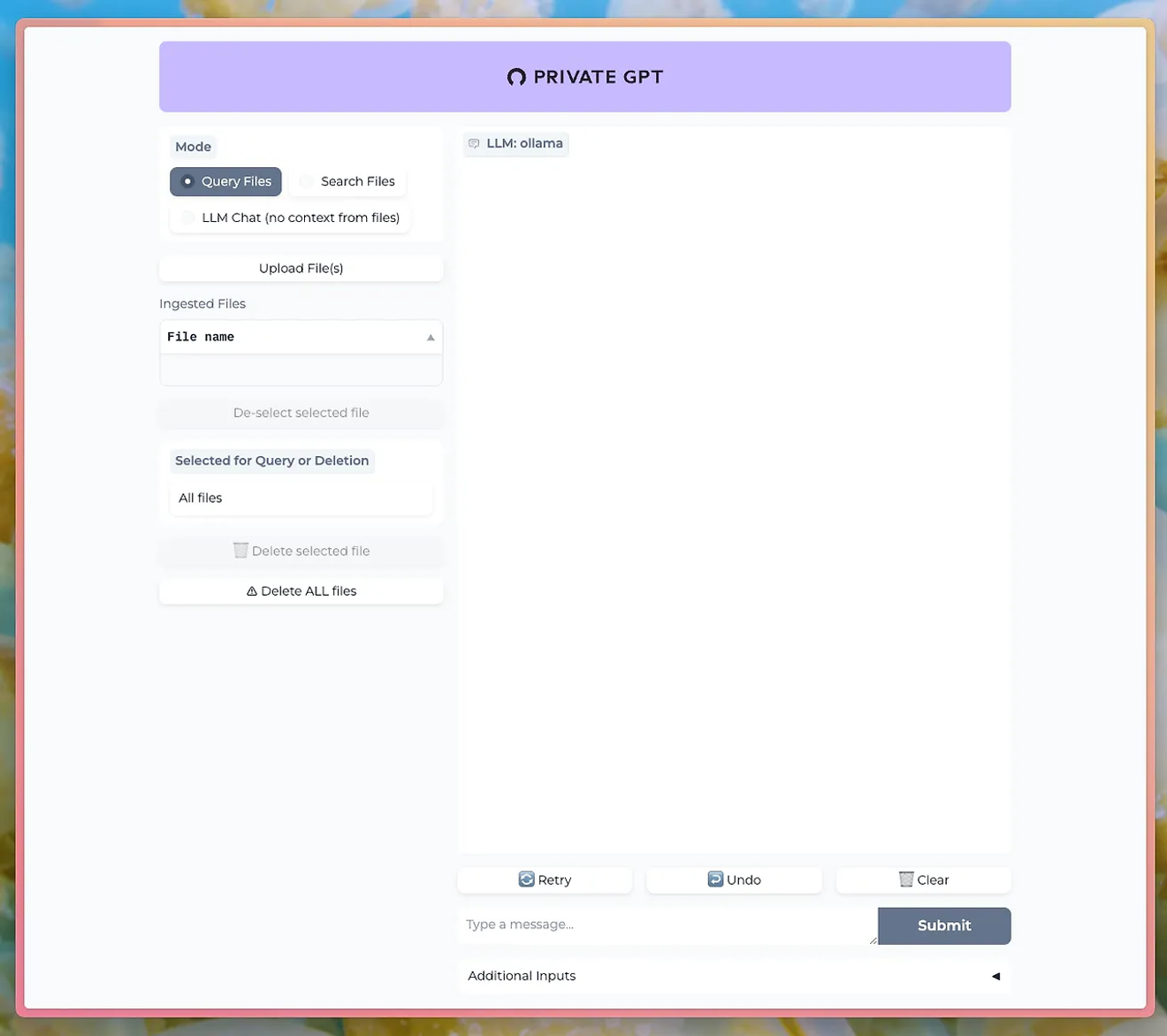

Utilizzando strumenti come PrivateGPT, è possibile interagire con l'LLM di Ollama tramite un'interfaccia utente di chat.

http://PrivateGPT GitHub

Per utilizzare la funzione di caricamento dei documenti, è necessario installare il modello nomic-embed-text di Ollama.

Ollama consente di sperimentare le potenti funzionalità di elaborazione del linguaggio naturale, mantenendo al contempo la privacy e la sicurezza dei dati. Questo rappresenta un enorme vantaggio, soprattutto per le aziende o le ricerche in cui la sensibilità dei dati è fondamentale.

Impara ad usare Ollama ed esegui il tuo LLM locale. Non perdere l'opportunità di controllare direttamente le funzionalità di elaborazione del linguaggio naturale ad alte prestazioni e di verificare immediatamente i risultati.

Commenti0