Sujet

- #Modèle linguistique

- #LLM

- #Protection des données personnelles

- #Installation locale

- #Ollama

Création: 2024-11-09

Création: 2024-11-09 17:46

Ollama est un framework léger pour exécuter des modèles linguistiques locaux. Ce framework est conçu pour regrouper les poids, les paramètres et les jeux de données du modèle en un seul package intégré, optimisé pour une variété d'applications d'IA.

Vous pouvez télécharger les fichiers d'installation pour Mac, Linux et Windows sur la page d'accueil d'Ollama.

Une fois l'installation terminée, lancez l'application Ollama.

Vous pouvez saisir les commandes suivantes dans le terminal :

Ollama fournit également une API pour des interactions plus détaillées. Pour plus d'informations, veuillez visiter :

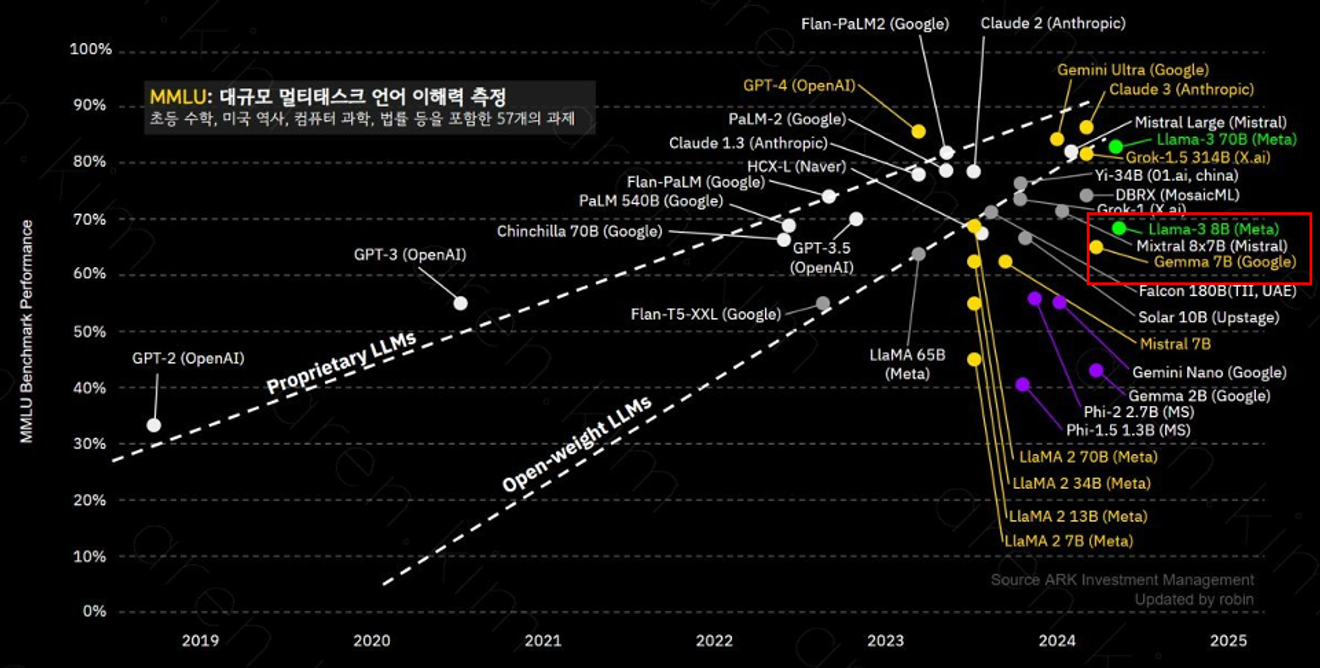

Ollama prend en charge une variété de modèles, parmi lesquels le modèle llama-3 8B, qui possède 800 millions de paramètres, excelle dans la compréhension de contextes complexes et la résolution de problèmes. Les performances de chaque modèle peuvent varier en fonction du nombre de paramètres et des données d'entraînement, il est donc important de choisir celui qui convient à vos besoins.

Le modèle llama-3 8B offre des performances similaires à celles de GPT-3.5.

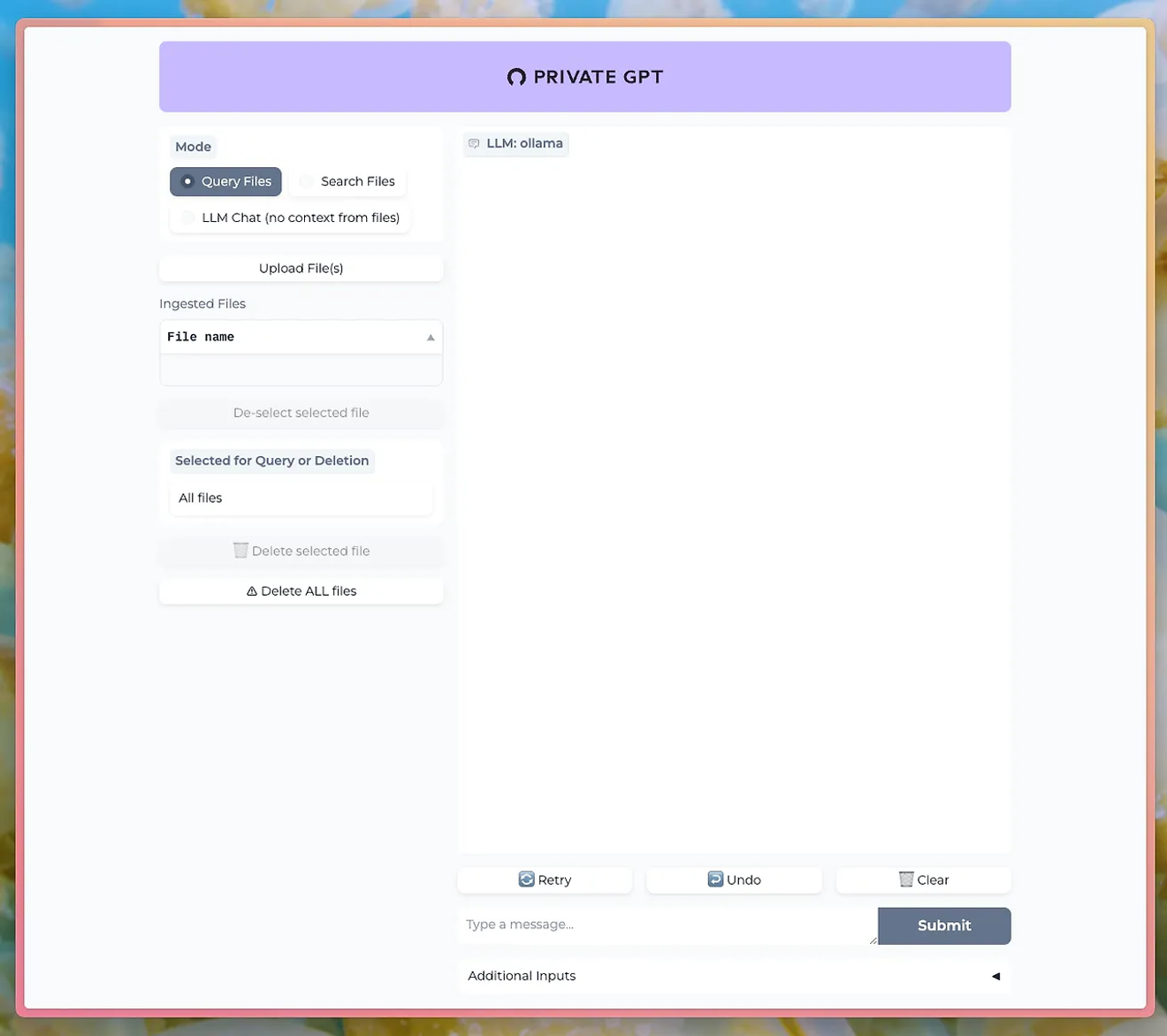

Des outils tels que PrivateGPT permettent d'utiliser le LLM d'Ollama pour discuter via une interface utilisateur de chat.

http://PrivateGPT GitHub

Pour utiliser la fonction de téléchargement de documents, vous devez installer le modèle nomic-embed-text d'Ollama.

En utilisant Ollama, vous pouvez profiter de puissantes fonctionnalités de traitement du langage naturel tout en maintenant la confidentialité et la sécurité de vos données. Ceci représente un avantage majeur, notamment pour les entreprises ou les recherches où la sensibilité des données est primordiale.

Apprenez à utiliser Ollama et exécutez votre propre LLM en local. Ne manquez pas l'opportunité de contrôler directement les fonctionnalités de traitement du langage naturel hautes performances et de voir les résultats instantanément.

Commentaires0