Tema

- #Modelo de lenguaje

- #Ollama

- #Protección de datos personales

- #Instalación local

- #LLM

Creado: 2024-11-09

Creado: 2024-11-09 17:46

Ollama es un framework ligero para ejecutar modelos de lenguaje locales. Este framework está diseñado para agrupar los pesos del modelo, la configuración y los conjuntos de datos en un único paquete integrado, optimizado para diversas aplicaciones de IA.

Puede descargar los archivos de instalación para Mac, Linux y Windows desde la página web de Ollama.

Una vez finalizada la instalación, ejecute la aplicación Ollama.

Puede introducir los siguientes comandos en la terminal:

Ollama también ofrece una API para interacciones más detalladas. Para más información, visite:

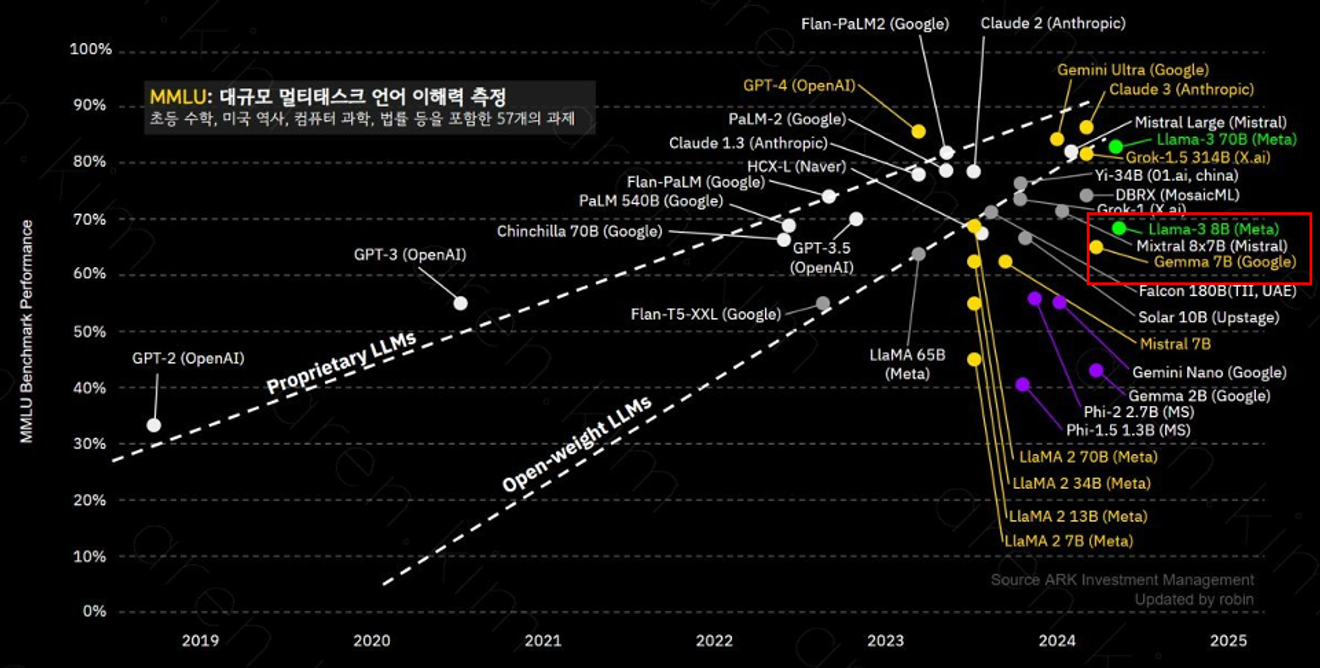

Ollama admite una variedad de modelos, entre los que destaca el modelo llama-3 8B, con 800 millones de parámetros, que destaca por su comprensión de contextos complejos y resolución de problemas. El rendimiento de cada modelo puede variar según el número de parámetros y los datos de entrenamiento, por lo que es importante elegir el que mejor se adapte a sus necesidades.

El modelo llama-3 8B ofrece un rendimiento similar al de GPT-3.5.

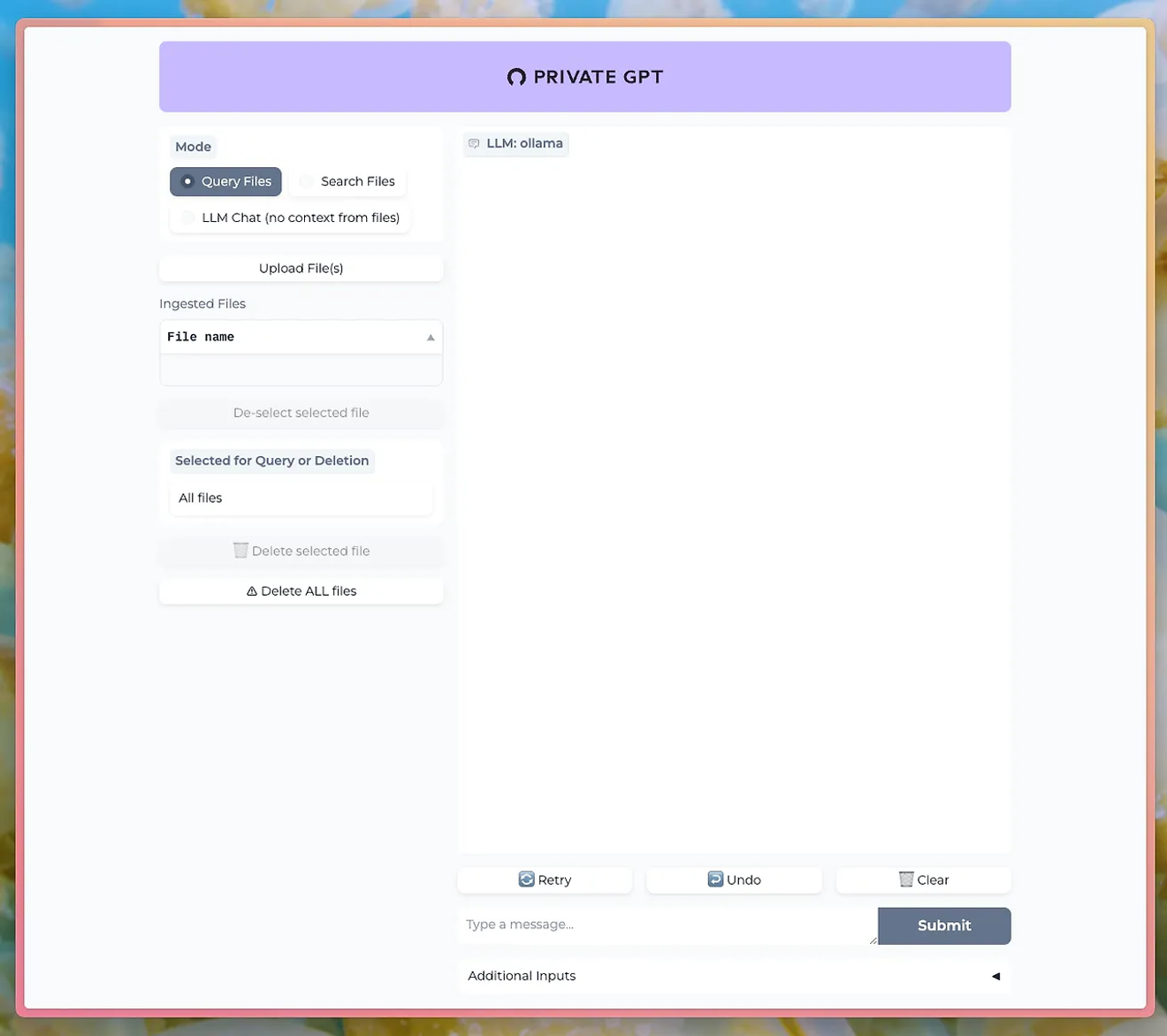

Utilizando herramientas como PrivateGPT, puede interactuar con el LLM de Ollama a través de una interfaz de usuario de chat.

http://PrivateGPT GitHub

Para utilizar la función de carga de documentos, debe instalar el modelo nomic-embed-text de Ollama.

Ollama permite experimentar el poder del procesamiento del lenguaje natural mientras se mantiene la privacidad y la seguridad de los datos. Esto resulta especialmente ventajoso en negocios o investigaciones donde la sensibilidad de los datos es crucial.

Aprenda a usar Ollama y ejecute su propio LLM localmente. No pierda la oportunidad de controlar directamente las funciones de procesamiento del lenguaje natural de alto rendimiento y ver los resultados al instante.

Comentarios0