Thema

- #LLM

- #Ollama

- #Datenschutz

- #Sprachmodell

- #Lokale Installation

Erstellt: 2024-11-09

Erstellt: 2024-11-09 17:46

Ollama ist ein leichtgewichtiges Framework zum Ausführen lokaler Sprachmodelle. Dieses Framework bündelt die Modellgewichte, Einstellungen und Datensätze in einem einzigen, integrierten Paket und ist für die Optimierung verschiedener KI-Anwendungen konzipiert.

Auf der Ollama-Website können Sie Installationsdateien für Mac, Linux und Windows herunterladen.

Nach der Installation führen Sie die Ollama-App aus.

Im Terminal können Sie folgende Befehle eingeben:

Ollama bietet auch eine API für detailliertere Interaktionen. Weitere Informationen finden Sie hier:

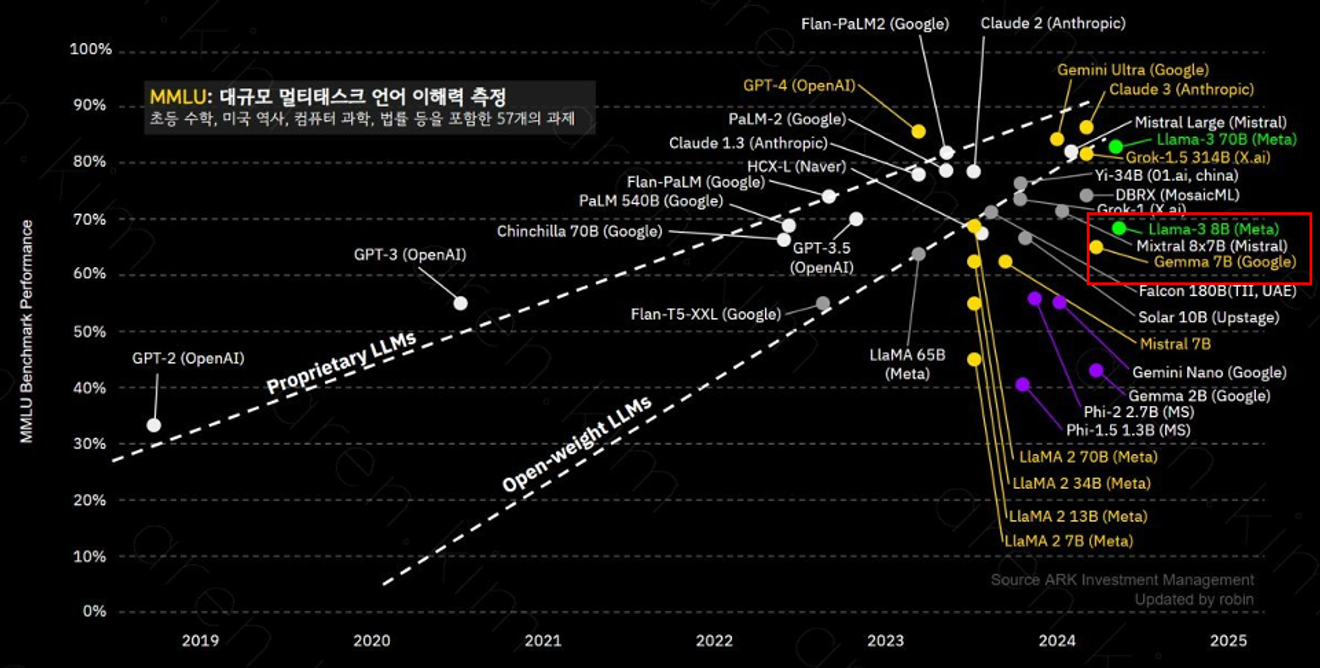

Ollama unterstützt verschiedene Modelle. Das llama-3 8B-Modell verfügt über 8 Milliarden Parameter und eignet sich hervorragend für komplexes Kontextverständnis und Problemlösung. Die Leistung der einzelnen Modelle kann je nach Anzahl der Parameter und Trainingsdaten variieren. Daher ist es wichtig, das Modell entsprechend dem Verwendungszweck auszuwählen.

Das llama-3 8B-Modell bietet eine ähnliche Leistung wie GPT-3.5.

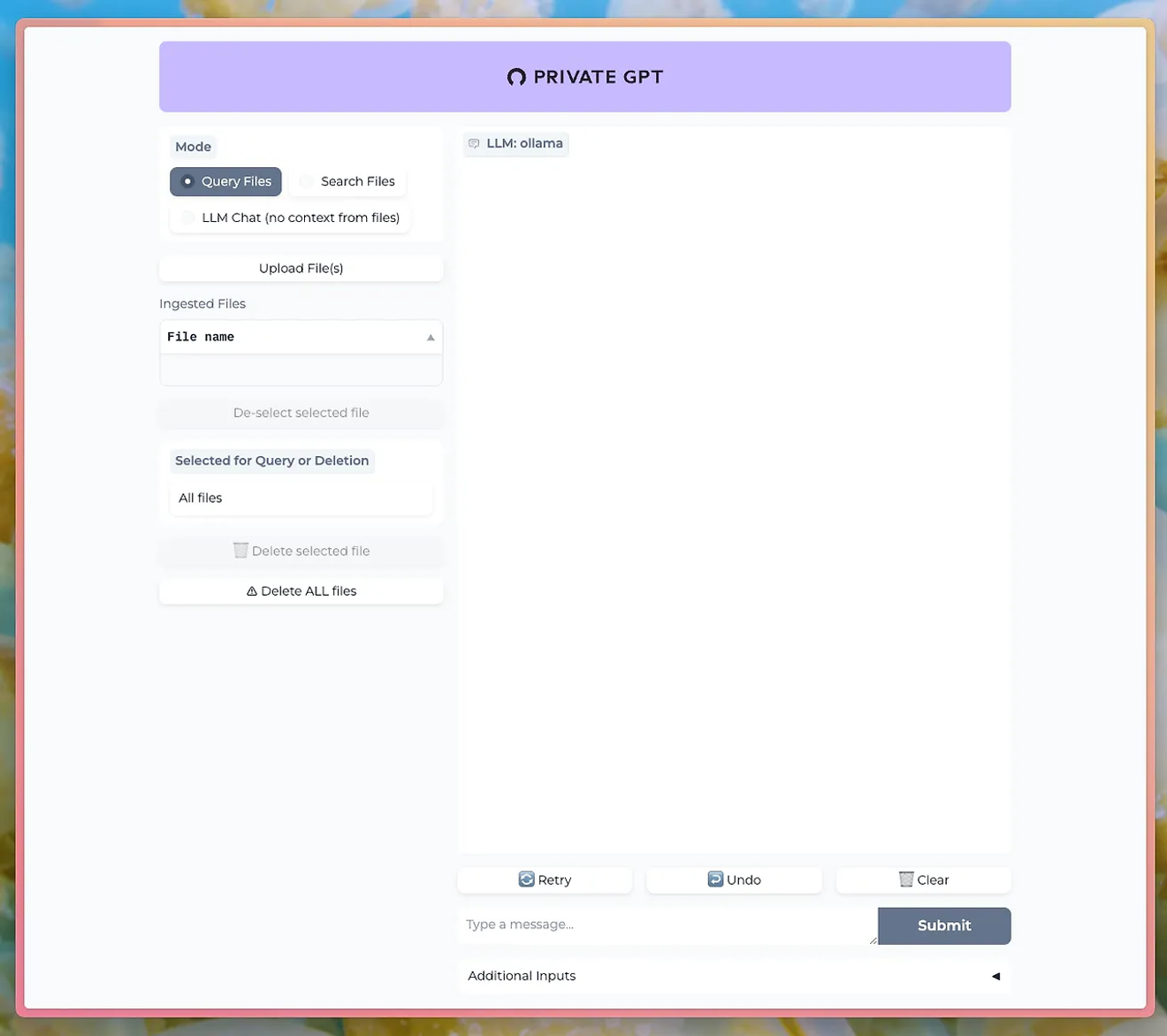

Mit Tools wie PrivateGPT können Sie über die LLM von Ollama über eine Chat-Benutzeroberfläche kommunizieren.

http://PrivateGPT GitHub

Um die Dokument-Upload-Funktion zu nutzen, müssen Sie das nomic-embed-text-Modell von Ollama installieren.

Mit Ollama können Sie die leistungsstarken Funktionen der Verarbeitung natürlicher Sprache erleben, während Sie gleichzeitig Ihre Privatsphäre und Datensicherheit wahren. Dies ist besonders vorteilhaft für Unternehmen oder Forschungsprojekte, bei denen die Datenvertraulichkeit von großer Bedeutung ist.

Erlernen Sie die Verwendung von Ollama und betreiben Sie Ihre eigene LLM lokal. Verpassen Sie nicht die Gelegenheit, die leistungsstarken Funktionen der Verarbeitung natürlicher Sprache selbst zu steuern und die Ergebnisse sofort zu sehen.

Kommentare0